امروزه هوش مصنوعی DeepSeek توجه زیادی را د به خود جلب کرده، زیرا باتوجه به اینکه هنوز در حال توسعه است، از Google Gemini و OpenAI ChatGPT عملکرد بهتری دارد، در حالی که هنوز در حال توسعه است. آنچه DeepSeek را منحصربهفرد میکند، کارایی بالا، تخصصی بودن، دسترسی بدون محدودیت و متنباز بودن آن است.

Deepseek چیست و چه کاربردهایی دارد؟

DeepSeek یک مدل زبانی بزرگ (LLM) است که به دلیل کارایی بالا، تخصصی بودن، دسترسی آزاد و متنباز بودن، جایگاه ویژهای پیدا کرده است. این مدل به گونهای طراحی شده که روی سختافزارهای ضعیفتر نیز اجرا شود و انرژی کمتری مصرف کند، بنابراین گزینهای مناسب برای محققان و توسعهدهندگانی است که به سختافزارهای پیشرفته دسترسی ندارند. DeepSeek بهطور ویژه برای تولید کد و پاسخدهی به سؤالات بهینه شده است، که آن را نسبت به مدلهای عمومی مانند Gemini و ChatGPT برای کاربردهای تخصصی مؤثرتر میکند. همچنین، این مدل متنباز است، به این معنی که هر فرد یا سازمانی میتواند از آن استفاده کند یا آن را تغییر دهد، که این امر باعث افزایش همکاری و نوآوری در جامعهی هوش مصنوعی میشود.

بیشتر بخوانید: “هوش مصنوعی deepseek برای اندروید”

سیستم مورد نیاز برای اجرای deepseek در ویندوز

| مولفه | حداقل مشخصات | مشخصات پیشنهادی |

|---|---|---|

| کارت گرافیک (GPU) | NVIDIA RTX 3090 (24GB VRAM) | NVIDIA RTX 4090 / A100 (40GB+ VRAM) |

| پردازنده (CPU) | پردازنده ۸ هستهای (Intel i7 / AMD Ryzen 7) | پردازنده ۱۶ هستهای (Intel i9 / AMD Ryzen 9) |

| حافظه رم (RAM) | ۳۲ گیگابایت | ۶۴ گیگابایت یا بیشتر |

| فضای ذخیرهسازی | ۱۰۰ گیگابایت SSD | ۱ ترابایت NVMe SSD |

| سیستم عامل (OS) | ویندوز ۱۰/۱۱ | ویندوز ۱۱ |

| پشتیبانی از Docker | WSL2 فعال باشد | WSL2 فعال باشد |

نحوه دانلود و استفاده از هوش مصنوعی deepseek برای windows

نصب DeepSeek-R1 با استفاده از Ollama

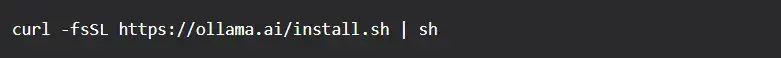

گام ۱: نصب Ollama

Ollama ابزاری ساده برای اجرای مدلهای زبانی بزرگ (LLM) بهصورت محلی است. برای نصب آن مراحل زیر را دنبال کنید:

دستور زیر را در ترمینال اجرا کنید تا Ollama نصب شود:

سپس سرویس Ollama را راهاندازی کنید

![]()

برای بررسی نصب موفق، دستور زیر را اجرا کنید:

![]()

اگر Ollama به درستی نصب شده باشد، شماره نسخه نمایش داده میشود (مثلاً ollama version 0.1.25).

گام ۲: دانلود و نصب DeepSeek-R1

DeepSeek-R1 ممکن است بهطور مستقیم در کتابخانه پیشفرض Ollama موجود نباشد. در این صورت، یکی از دو روش زیر را دنبال کنید:

روش ۱: دریافت از Ollama

![]()

ابتدا بررسی کنید که آیا مدل در Ollama موجود است:

![]()

اگر deepseek-r1 در فهرست نمایش داده شد، آن را دانلود کنید:

اگر deepseek-r1 در لیست نبود، به روش ۲ بروید.

روش ۲: نصب دستی با استفاده از Modelfile

گام ۱: دانلود مدل

مدل DeepSeek-R1 را در فرمت GGUF از منابعی مانند Hugging Face یا مخزن رسمی DeepSeek دریافت کنید و در پوشهای مانند ~/models ذخیره کنید.

گام دوم: ایجاد Modelfile

در همان پوشه، فایلی به نام Modelfile ایجاد کرده و محتوای زیر را داخل آن قرار دهید:

![]()

نام فایل را متناسب با مدل دانلودشده تغییر دهید.

ساخت مدل:

![]()

گام ۳: اجرای DeepSeek-R1

پس از نصب، میتوانید مدل را اجرا کنید:

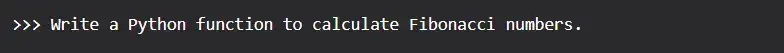

برای تست، میتوانید یک درخواست ارسال کنید:

گام ۴: اجرای DeepSeek در رابط وب

در حالی که Ollama امکان تعامل از طریق خط فرمان را فراهم میکند، یک رابط گرافیکی وب استفاده از آن را آسانتر میکند.

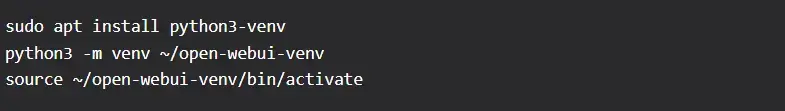

ایجاد محیط مجازی Python

نصب Open WebUI

راهاندازی سرور

حالا مرورگر خود را باز کنید و به http://localhost:8080 بروید. رابط کاربری وب Ollama باید نمایش داده شود.

مشکلات رایج دانلود هوش مصنوعی DeepSeek در Ollama

۱. مدل پیدا نشد:

- مطمئن شوید که نام مدل صحیح است یا از روش نصب دستی GGUF استفاده کنید.

- رجیستری مدل Ollama را برای مدلهای جایگزین DeepSeek بررسی کنید.

۲. مشکلات عملکردی:

- RAM/VRAM بیشتری اختصاص دهید.

- ورودیها را سادهتر کنید تا پاسخها سریعتر پردازش شوند.

۳. خطاهای WSL:

WSL را بهروزرسانی کنید:

سرویس Ollama را مجدداً راهاندازی کنید.

نصب DeepSeek با Python و Hugging Face

گام ۱: نصب پیشنیازها

ابتدا مطمئن شوید که Python روی سیستم شما نصب شده است. میتوانید با اجرای دستور زیر نسخهی پایتون را بررسی کنید:

گام ۲: دانلود مدل

DeepSeek-R1 را در Hugging Face Model Hub پیدا کنید.

مخزن را با استفاده از دستور زیر کلون کنید:

گام ۳: اجرای مدل

یک اسکریپت پایتون (inference.py) ایجاد کنید:

گام ۴: اجرای اسکریپت

نصب DeepSeek با Docker

اجرای DeepSeek بهصورت محلی با Docker یک محیط ساده و قابلاعتماد فراهم میکند و بسیاری از پیچیدگیهای نصب دستی را حذف میکند.

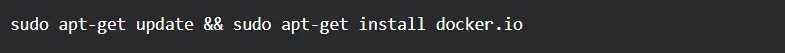

گام ۱: نصب Docker

اطمینان حاصل کنید که Docker و Docker Compose روی سیستم شما نصب شدهاند. میتوانید آنها را از وبسایت رسمی Docker (docker.com) دانلود و نصب کنید.

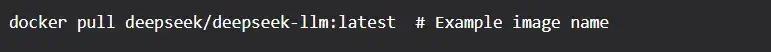

گام ۲: دریافت ایمیج Docker

ایمیج رسمی را از رجیستری دریافت کنید (نام deepseek-image:tag را با نام واقعی ایمیج از مستندات DeepSeek جایگزین کنید):

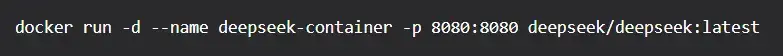

گام ۳: اجرای کانتینر DeepSeek

کانتینر را با منابع مناسب اجرا کنید:

این دستور کانتینر را در حالت جداگانه (-d) اجرا کرده، نام آن را deepseek-container تنظیم میکند و پورت ۸۰۸۰ کانتینر را به ۸۰۸۰ روی سیستم محلی مپ میکند.

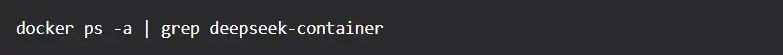

گام ۴: بررسی نصب

بررسی کنید که کانتینر در حال اجرا است:

گام ۵: تعامل با مدل

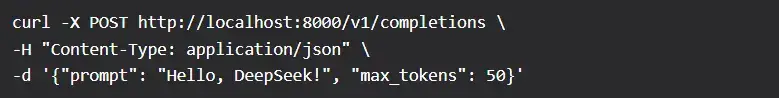

یک درخواست تست از طریق API ارسال کنید:

نصب DeepSeek با llama.cpp

برای استفاده با CPU یا GPU سبک.

پیشنیازها

- سختافزار:

CPU: پردازندههای x86-64 یا ARM

GPU (اختیاری): NVIDIA (CUDA)، AMD (ROCm)، یا Apple Metal

- نرمافزار:

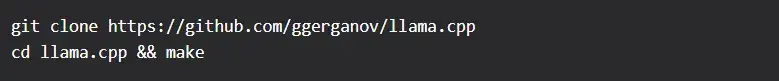

گام ۱: کلون مخزن llama.cpp

گام ۲: ساخت پروژه

این دستور یک فایل اجرایی در دایرکتوری build/bin ایجاد میکند.

گام ۳: دانلود مدل GGUF

گزینه ۱: یک مدل GGUF از پیش تبدیلشده را از Hugging Face دانلود کنید:

در Hugging Face Hub برای deepseek-gguf جستجو کنید (نام مدل را متناسب با نسخهی موردنظر خود تنظیم کنید).

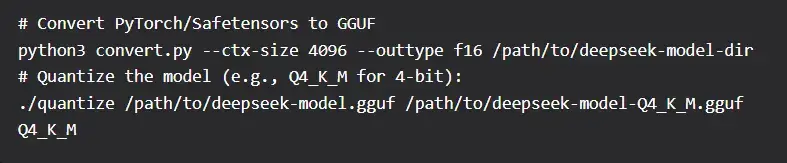

گزینه ۲: مدل خام را خودتان به GGUF تبدیل کنید (پیشرفته):

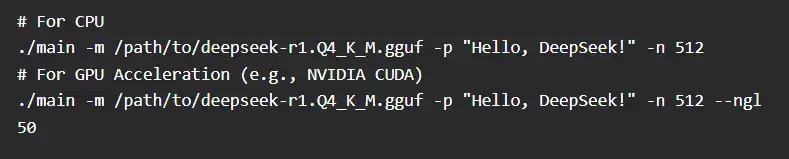

گام ۴: اجرای مدل

از فایل اجرایی اصلی برای تعامل با مدل استفاده کنید:

مشکلات رایج و راه حل های نصب DeepSeek با llama.cpp

- سازگاری مدل: اطمینان حاصل کنید که مدل DeepSeek با llama.cpp سازگار است. اگر فرمت متفاوتی دارد، ممکن است نیاز به تبدیل آن با ابزارهای مناسب داشته باشید.

- مشکلات حافظه: اگر با خطاهای کمبود حافظه مواجه شدید، از نسخههای کوانتیزهشده مدل (مانند .ggml.q4_0 یا .gguf.q5_1) استفاده کنید تا مصرف منابع کاهش یابد.

- عملکرد: برای بهبود عملکرد، در صورت پشتیبانی سیستم، از شتابدهنده GPU استفاده کنید.

جمعبندی

روشهای مختلفی برای دانلود هوش مصنوعی deepseek برای ویندوز وجود دارد که هر کدام بسته به نیاز کاربران و منابع سختافزاری، مزایای خاص خود را دارند. Ollama سادهترین روش برای اجرای محلی است و برای کاربرانی که به دنبال نصب سریع هستند، گزینهای ایدهآل محسوب میشود. Python و Hugging Face انعطافپذیری بیشتری برای محققان و توسعهدهندگان فراهم میکنند، در حالی که Docker یک محیط پایدار و ایزوله برای اجرای مدل ایجاد میکند. llama.cpp نیز برای سیستمهایی که فقط از CPU استفاده میکنند، مناسب است. اگرچه DeepSeek یک مدل رایگان و متنباز است، اما انتخاب بهترین روش اجرا بستگی به توان پردازشی سیستم، دانش فنی کاربر و نوع استفاده از مدل دارد.

سوالات متداول دانلود هوش مصنوعی deepseek برای ویندوز

۱. آیا DeepSeek رایگان است؟

بله، DeepSeek بهصورت رایگان و بدون محدودیت در تعداد مکالمات در دسترس است. با این حال، در ساعات پرترافیک ممکن است پردازش درخواستها کمی طول بکشد.

۲. آیا میتوان DeepSeek را روی ویندوز اجرا کرد؟

بله، میتوان DeepSeek را روی ویندوز ۱۰ و ۱۱ اجرا کرد. روشهای مختلفی مانند نصب از طریق Ollama، اجرای مدل از طریق Docker یا استفاده از Python و Hugging Face برای این کار وجود دارند.

۳. برای اجرای DeepSeek به چه سختافزاری نیاز داریم؟

برای اجرای روان DeepSeek، حداقل یک پردازندهی ۸ هستهای (Intel i7 / AMD Ryzen 7)، کارت گرافیک RTX 3090 (۲۴ گیگابایت VRAM) و ۳۲ گیگابایت RAM نیاز است. اما برای عملکرد بهینه، پیشنهاد میشود از RTX 4090 یا A100 با ۴۰ گیگابایت VRAM و ۶۴ گیگابایت RAM استفاده کنید.

۴. چه تفاوتی بین DeepSeek و مدلهایی مثل ChatGPT یا Gemini وجود دارد؟

DeepSeek بیشتر برای وظایف خاص مانند تولید کد و پاسخدهی به سؤالات تخصصی بهینه شده است. همچنین، برخلاف ChatGPT و Gemini که توسط شرکتهای خصوصی کنترل میشوند، DeepSeek یک مدل متنباز است که هر کسی میتواند از آن استفاده کند یا آن را تغییر دهد.

۵. آیا میتوان DeepSeek را بهعنوان یک اپلیکیشن روی ویندوز نصب کرد؟

DeepSeek اپلیکیشن بومی (Native App) برای ویندوز ندارد، اما میتوان آن را از طریق Microsoft Edge یا Google Chrome بهعنوان یک برنامهی وب پیشرونده (PWA) نصب کرد و از آن بهصورت یک اپلیکیشن مستقل در دسکتاپ استفاده کرد.